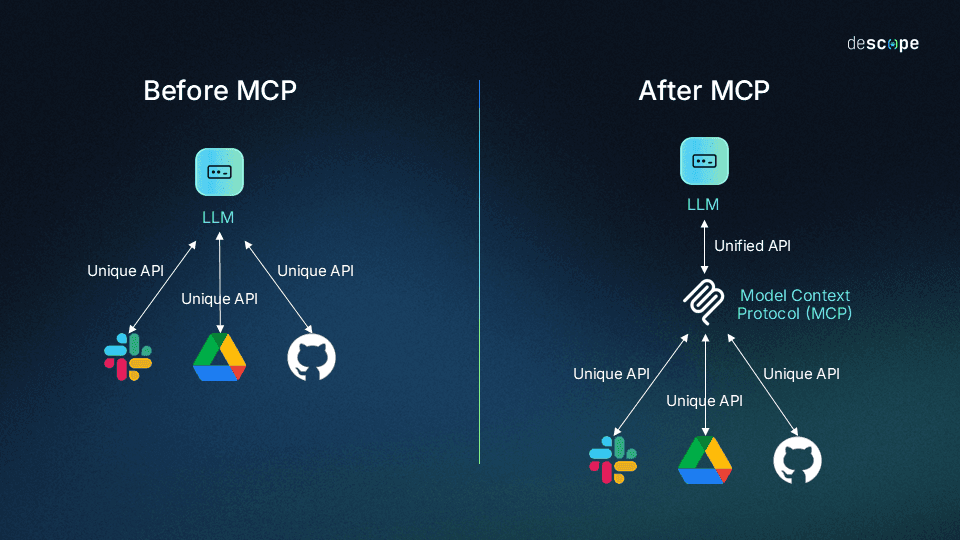

Model Context Protocol (MCP) to protokół stworzony przez Anthropic, który standaryzuje podejście w jaki aplikacje dostarczają kontekst dla Large Language Models (LLM). Możnaby określić MCP jako port USB-C dla aplikacji AI. MCP umożliwiają budowanie agentów opartych o LLM.

Poniższe linki pomogą Ci zrozumieć i wykorzystać potencjał MCP:

- Model Context Protocol (MCP)

- Awesome MCP Servers

- Terraform MCP Server

- What Is the Model Context Protocol (MCP) and How It Works

- Extending GitHub Copilot Chat with the Model Context Protocol (MCP)

- AWS MCP Servers

- Azure MCP Server

Kluczem zrozumienia protokołu MCP jest słowo kontekst, ponieważ definiuje on sposób, w jaki aplikacje mogą dostarczać istotne informacje dla LLM, co pozwala lepiej rozumieć intencje użytkowników i dostarczać bardziej trafne odpowiedzi.

Poniższy schemat pozwoli Ci dostrzec główną zaletę MCP jaką on pełni w stosunku do wielu API oraz LLM:

źródło: https://www.descope.com/learn/post/mcp

Jeśli chciał_byś spróbować zbudować własny serwer MCP, warto skorzystać z SDK np. dla Python’a. Serwer MCP udostępnia:

narzędzia(tools),zasoby(resources),podpowiedzi(prompts).

Komunikacja między klientem a serwerem możliwa jest za pomocą 2 sposobów:

stdio, czyli transport po standardowej komunikacji wejście/wyjście,streamable HTTP, czyli nowy protokół komunikacji po HTTP dostarczany wraz z MCP w wersji2025-03-26.

Warto zapoznać się z dostępnymi i gotowymi do użycia serwerami MCP, w szczególności:

Z kolei przy budowanie klienta MCP, warto przeanalizować przykładowy kod źródłowy np. dla Python’a.

Co jeszcze warto przeczytać na temat MCP? Moim zdaniem specyfikacje protokołu, ponieważ szczegółowo opisuje ona cykl życia, sposób transportu danych między klientem a serwerem, a także najlepsze praktyki dotyczące np. bezpieczeństwa.